Prineras experiencias comerciales

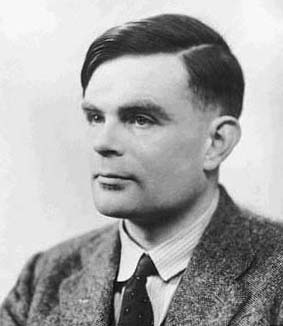

Turing puede considerarse como el padre I.A., aunque este nombre no se usase hasta después de 1956. Turing estudió lógica matemática en la universidad de Cambridge. En 1937 publicó una ponencia sobre "números computables" donde expuso el concepto de la "maquina universal de Turing" afirmando que la maquina puede desarrollar cualquier procedimiento matemático siempre que se le proporcione una tabla adecuada de instrucciones.

|

Durante la segunda guerra mundial

lidero el proyecto británico para descifrar el código

militar Alemán "enigma",el resultado de este proyecto

fueron las maquinas electromecánica Robinson y la maquina

electrónica Colossus, que fueron vitales para los aliados

para descifrar los mensajes alemanes durante la 2 guerra,echo por

el cual nunca recibió en vida reconocimiento alguno de la

sociedad a la que tanto ayudo en sus momentos difíciles.

|

Después de la 2 guerra marcho al National

Physical Laboratory, en Teddington, para contribuir en el diseño

de ACE(Automatic Computing Engine). Condenado a causa de su Homosexualidad a un tratamiento, o tortura, médico-farmaceutica equivalente a la castración, Turing se suicidó por envenenamiento en 1954. |